سلام خدمت کاربران عزیز سورس باران. بعضی از عزیزان در زمینه بهینه کردن فایل Robots.txt مشکلاتی داشتن که توی این پست تصمیم گرفتیم آموزش بهینه کردن فایل Robots.txt با راه حلی ساده و کوتاه رو در اختیارتون قرار بدیم. توی این آموزش کوتاه و مفید به راحتی فایل Robots.txt خودتون رو بخوبی بهینه می کنید که در نتیجه روی سئو سایت شما تاثیر بسیار خوبی خواهد داشت. شاید برا خیلیا این سوال پیش بیاد که Robots.txt چیه؟ بطور کلی میشه گفت Robots.txt با موتور های جستجو که مهمترین اونا گوگله ارتباط برقرار می کنه و به اونا میگه که چه بخش هایی از سایت رو ایندکس و در نتایج جستجو نشون بده.

جهت مشاهده آموزش بهینه کردن فایل Robots.txt با راه حلی ساده به ادامه مطلب مراجعه نمایید.

آیا وجود Robots.txt ضرورتی داره؟ فایل Robots.txt در کجا قرار دارد؟

نبود این فایل، مشکلی جهت ایندکس مطالب شما و خزش مورتوهای جستجو توی سایتتون نداره اما همون طور که در بالا گفتم وجود این فایل میتونه کمک زیای به بهبود سئوی کلی سایت شما بکنه و نتیجه بهتری بگیرید. .نهایتا بنده بهتون پیشنهاد میکنم که سعی کنید فایل Robots.txt رو برا سایتتون بسازین. اگه میخواین نقشه ی xml سایتتون رو به موتورهای جستجو بفرستین، این دقیقا بهترین جایی هست که مورتوهای جستجو به دنبال نقشه ی سایت شما می گردن، مگر اینکه اون رو در Google Webmaster Tools مشخص نکرده باشین.

معمولا این فایل در ریشه سایت یعنی پوشه public_html موجود است که با ورود به هاست خودتون می تونید اونو ویرایش کنید.

نحوه استاده از فایل Robots.txt به چه شکله؟

همونطور که خیلی از دوستان میدونن ساختار این فایل بسیار ساده و قابل فهمه. اولین خط که user agent نامیده میشه، در واقع نام ربات جستجویی هست که شما باهاش ارتباط برقرار می کنین، مثلا ربات گوگل (Googlebot)، ربات بینگ (Bingbot) و برای شامل کردن تمام ربات ها هم می تونین، علامت * رو در مقابلش قرار بدین. خطوط بعدی ساختارهای مجاز و غیرمجاز برای ایندکس شدن رو نشون میدن، یعنی شما می تونین مشخص کنین ربات، مجازه کدوم شاخه ها رو ایندکس کنه و کدوم شاخه ها رو مجاز نیست. فایل زیر یه نمونه از فایل robots.txt هست که تمام ربات های جستجوگر رو فراخوانی میکنه و در ضمن به شاخه ی آپلود تصاویر رو برای ایندکس شدن مجاز میدونه و دو شاخه ی دیگه رو غیرمجاز میدونه.

User-Agent: * Allow: /wp-content/uploads/ Disallow: /wp-content/plugins/ Disallow: /readme.html

بهینه کردن فایل Robots.txt با راه حلی ساده :

گوگل به وبمسترها توصیه می کنه که از فایل robots.txt برای پنهان کردن محتوای کم کیفیتشون استفاده نکنن. بذارین راحت تر بگم، اگه شما با استفاده از فایل robots.txt، گوگل رو از ایندکس کردن شاخه هایی مثل دسته بندی ها، تاریخ و … منع کنید، به هیچ وجه کار عاقلانه ای نکردین. البته به یاد داشته باشین که هدف فایل robots.txt اینه که با فایل های سایت شما چه برخوردی کنه، اما در هر صورت اون ها رو بررسیخواهد کرد.

نیازی نیست که صفحاتی مثل صفحه ی ورود، شاخه ی مدیریت (admin) یا صفحه ی ثبت نام رو به فایل robots.txt اضافه کنین، چرا که این صفحات به صورت پیش فرض دارای برچسب noindex هستن و ایندکس نمیشن. توصیه میشه که فایل readme.html را در robots.txt غیرمجاز کنین. چرا؟ چون این فایل ممکنه توسط بعضی از افراد برای فهمیدن نسخه ی وردپرس شما استفاده بشه و در نتیجه غیرمجاز کردن اون باعث جلوگیری از برخی حملات مخرب میشه.

آموزش افزودن نقشه ی XML سایت به فایل robots.txt :

اگر از پلاگین هایی مثل WordPress SEO by Yoast و … برای تولید نقشه ی سایتتون استفاده می کنین، این پلاگین ها، به صورت اتوماتیک، نقشه ی سایتتون رو به فایل robots.txt اضافه خواهد کرد. اما اگه پلاگین موفق به انجام این کار نشد، شما اینکار رو باید به صورت دستی انجام بدین، یعنی همون آدرسی که توی پلاگین برای نقشه ی سایت گذاشته شده رو باید استفاده کنین. کدهای زیر یه نمونه رو نشون میدن.

Sitemap: http://www.example.com/post-sitemap.xml Sitemap: http://www.example.com/page-sitemap.xml

در زیر هم یک فایل robots.txt رو به همراه بخش هایی که میتونه داشته باشه رو می بینید(البته فایل robots.txt می تونه متناسب به نیاز شما ساخته شده باشه)

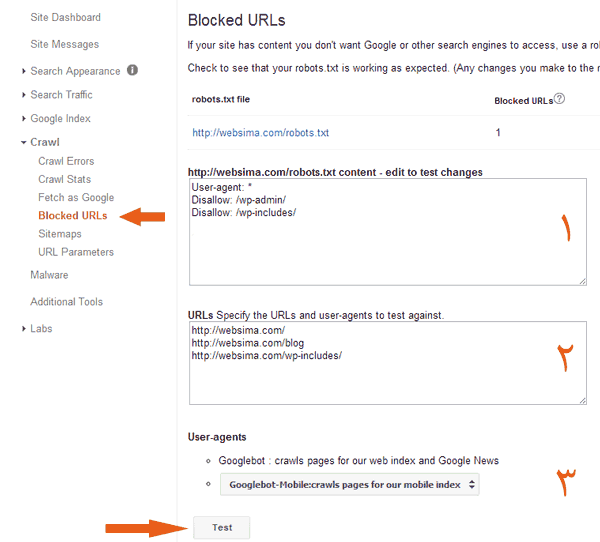

آزمایش Robots.txt در بخش Blocked URLs وبمستر :

وبمستر گوگل قسمت مشخصی را برای نمایش صفحاتی از سایت شما که توسط robots.txt دسترسی روبات به آنها محدود شده، در نظر گرفته است. این صفحه با نام Blocked URLs و بعنوان زیر مجموعه ای از بخش Crawl تعریف شده است.برای اطمینان از عملکرد صحیح فایل robots.txt به بخش Blocked URLs در اکانت وبمستر خود مراجعه کرده و مانند تصویر زیر در بخش اول محتویات فایل را کپی کنید. در بخش دوم آدرس صفحاتی که قصد دارید میزان محدودیت روبات های گوگل در دسترسی به آنها را بسنجید وارد کنید. (در هر خط یک آدرس)

در بخش انتهایی شما میتوانید یک نوع از روبات های گوگل را علاوه بر روبات اصلی که وظیفه ایندکس صفحات را برعهده دارد انتخاب کنید.

با فشردن دکمه Test نتایج آزمون و میزان دسترسی روبات ها به هریک از این آدرس ها به شما نمایش داده خواهد شد.

نحوه انتخاب صفحاتی که در فایل robots.txt معرفی میشوند و پنهان کردن آنها از دید موتورهای جستجو وابستگی مستقیم با سیاست های شما در انتشار محتوا و سئو سایت خواهد داشت. قبل از انجام تغییرات اساسی در این فایل حتما با متخصصان سئو مشورت کرده و کدهای وارد شده را چندین بار آزمون و بازنویسی نمایید. در صورتیکه در مورد هریک از موارد عنوان شده در این مقاله سوال یا ابهامی دارید میتوانید در بخش نظرات مطرح کرده و تا حد توان کارشناسان وبسیما پاسخ گوی شما خواهند بود.

راستی! برای دریافت مطالب جدید در کانال تلگرام یا پیج اینستاگرام سورس باران عضو شوید.

- انتشار: ۳۰ دی ۱۳۹۴

دسته بندی موضوعات

- آموزش برنامه نویسی

- آموزش کریپتو کارنسی (ارز دیجیتال)

- آموزش متنی برنامه نویسی

- پروژه برنامه نویسی

- فروشگاه

- فیلم های آموزشی

- #F

- ++C

- 3ds max

- Ada

- ADO.NET

- Adobe Flash

- Agile

- Ajax

- AngularJS

- Anime Studio

- apache

- ARM

- Asp.Net

- ASP.NET MVC

- assembly

- AVR

- Azure

- Bootstrap

- Cassandra

- CCNA

- CCNP

- CCSP

- ChatGPT

- Cisco

- CMD

- COBOL

- CSS

- Cython

- Django

- Dreameaver

- Elixir

- EntityFramework

- Erlang

- Flash

- Go

- Groovy

- Haskell

- Htaccess

- HTML

- IOS

- Jade

- jquery

- Kendo UI

- Linq

- Linux

- LUA

- MariaDB

- maya

- Meteor

- MongoDB

- Mono Android

- MonoGame

- Mysql

- NoSQL

- Oracle

- Orchard

- Perl

- php

- PHPMyAdmin

- R

- Rational Rose

- Ruby

- Rust

- Scala

- Scrum Master

- SFML

- SharePoint

- SignalR

- silver light

- SQL Server

- Stimulsoft Reports

- Telerik

- UML

- VB.NET&VB6

- Vue 3

- WPF

- Xml

- آردوینو

- آموزش های پروژه محور

- آیونیک

- اتوکد

- الگوریتم تقریبی

- الگوریتم نویسی و فلوچارت

- امنیت

- اندروید

- اندروید استودیو

- انیمیشن سازی

- بازی سازی با Scratch

- بک ترک

- بیسیک فور اندروید

- پایتون

- پرولوگ

- پریمیر

- جاوا

- جاوا اسکریپت

- جنگو

- جوملا

- دارت

- دلفی

- دوره های رایگان پیشنهادی

- زامارین

- سئو

- ساخت CMS

- ساخت اتوران

- ساختمان داده ها

- سی شارپ

- شبکه و مجازی سازی

- طراحی الگوریتم

- طراحی بازی

- طراحی وب

- فتوشاپ

- فریم ورک codeigniter

- فلاتر

- کاتلین

- کامپایلرها

- کانستراکت

- کریستال ریپورت

- کلوژر

- گوگل آنالیتیکس

- گیت

- لاراول

- مای بی بی

- مایکروسافت پروجکت

- متریال دیزاین

- متلب

- معماری کامپیوتر

- مهندسی اینترنت

- میکروتیک

- نود جی اس

- نیوک

- هوش مصنوعی

- ویبولوتین

- ویژوال استودیو

- یونیتی

- کتاب های آموزشی

- Ada

- Ajax

- Android

- ASP.NET

- ASP.NET Core

- AVR

- clips

- CNC

- COBOL

- CQRS

- Cython

- Dreamweaver

- Elixir

- Entity Framework 4.0

- Erlang

- Go

- Groovy

- Haskell

- LINQ

- Lua

- Matlab

- MFC

- Node.js

- PERL

- php

- PLC

- Prolog

- React

- Rust

- Scala

- SFML

- SharePoint

- silver light

- VHDL

- VMware

- WinJS

- Workflow

- WPF

- XHTML

- Yii Framework

- اتوکد

- اچ تی ام ال

- اسمبلی

- اکتیو ایکس

- الگوریتم و فلوچارت

- انگولار

- اوبونتو

- اوراکل

- بازی سازی

- بانک اطلاعاتی

- برنامه نویسی سوکت

- برنامه نویسی موبایل

- بک ترک

- پاسکال

- پایان نامه

- پایتون

- پرولوگ

- جاوا

- جاوا اسکریپت

- جی کوئری

- حوملا

- داده کاوی

- دلفی

- رباتیک

- روبی

- زبان ماشین

- سئو

- ساختمان داده ها

- سایر کتاب ها

- سخت افزار

- سوئیفت

- سی اس اس

- سی پلاس پلاس

- سی شارپ

- سیستم عامل

- سیستم های خبره

- شبکه و مجازی سازی

- شبیه سازی کامپیوتر

- طراحی الگوریتم

- فتوشاپ

- فریم ورک گتنا

- کاتلین

- کالی لینوکس

- کریستال ریپورت

- گزارش کارآموزی

- گوگل

- لیسپ

- متلب

- مقاله

- مهندسی نرم افزار

- نیوک

- هوش مصنوعی

- وب مستر

- ویژوال بیسیک

- نرم افزار و ابزار برنامه نویسی

- وردپرس